ChatGPT prohíbe repetir una palabra porque acaba revelando datos personales

Pedirle a ChatGPT que repita una palabra eternamente ahora es una violación de las políticas de uso

MADRID, Santo Domingo, 5 de diciembre de 2023.- ChatGPT ya no puede repetir una palabra eternamente porque ahora se advierte de que se trata de una posible violación de sus políticas, un cambio que se ha apreciado tras una investigación que demostraba que dicha repetición acababa revelando datos personales reales procedentes del entrenamiento.

Una reciente investigación en la que participó Google DeepMind y que recoge Europa Press, mostró que ChatGPT puede revelar datos personales, como un número de teléfono o una dirección de correo electrónico, en un ciberataque "algo tonto", en el que solo hay que repetir que pedirle que repita eternamente una palabra, .

Este ataque de extracción de datos se basa en que "los modelos de imágenes y texto memorizan y regurgitan datos de entrenamiento", como apuntaron los investigadores- Unas veces estos datos aparecen sin que nadie intente extraerlos, pero puede forzarse su aparición de una forma muy simple.

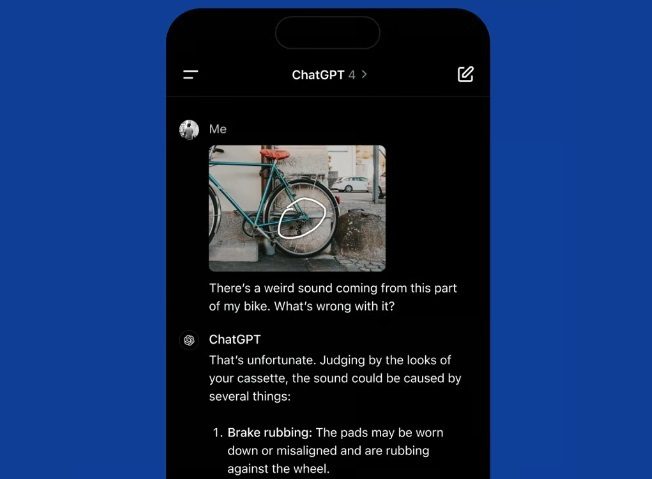

Tras desvelarse la investigación, al intentar pedir a CharGPT que repita -cualquier palabra- eternamente, muestra una notificación que advierte de que dicha petición puede violar los términos de uso o la política de contenido.

Se trata de una acción que OpenAI, responsable de este 'chatbot', ha incluido ahora como una violación de los términos de uso del servicio, como informan en 404 Media. Tras desvelarse la investigación, al intentar pedir a CharGPT que repita -cualquier palabra- eternamente, muestra una notificación que advierte de que dicha petición puede violar los términos de uso o la política de contenido.

Sin embargo, esta advertencia no aparece por el momento recogida en las propias políticas de uso de ChatGPT, ni en los términos de uso ni en la política de contenido, como señalan en Edgadget y puede comprobarse en los documentos.

Artículos relacionados

ChatGPT se refuerza para afrontar crisis de salud mental de usuarios

OpenAI anuncia nuevas funciones para proteger a usuarios en momentos de angustia. En un esfuerzo por mejorar su capacidad para manejar situaciones delicadas, OpenAI ha…

Investigadores de UOC: ChatGPT cambia de personalidad según idioma y cultura

Prueban que la IA replica estereotipos culturales. Las respuestas varían al cambiar idioma o país de referencia NUEVA YORK.-Un estudio pionero de la Universitat Oberta…

Tus fotos pueden delatarte: ChatGPT ya reconoce lugares

Compartir imágenes en vacaciones podría exponer tu ubicación exacta sin permiso En plena temporada de Semana Santa, muchas personas aprovechan para escaparse a la playa,…